- 05/11

- 2023

-

QQ扫一扫

-

Vision小助手

(CMVU)

前言

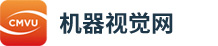

边缘检测是计算机视觉领域的一项基本任务,是视觉场景识别和理解的重要预处理操作。在常规模型中,生成的边缘图像模糊不清,边缘线也很粗,这通常需要使用非极大值抑制(NMS)和形态细化操作来生成清晰而细的边缘图像。

在今天分享中,研究者旨在提出一种无需后处理即可生成高质量边缘图像的单阶段神经网络模型。所提出的模型采用经典的编码器-解码器框架,其中使用预训练的神经模型作为编码器,并且将每个级别的特征相互融合的多特征融合机制作为可学习的解码器。

此外,研究者提出了一种新的损失函数,通过抑制真阳性(TP)边缘和假阴性(FN)、非边缘附近的假阳性(FP)边缘信息来解决边缘图像中的像素级不平衡问题。在几个基准数据集上进行的实验结果表明,所提出的方法在不使用NMS和形态细化操作的情况下实现了最先进的结果。

背景

在机器视觉检测设备中,缺陷检测作用是机器视觉检测设备使用最普遍的作用的一种,主要是检验产品表面的各类信息内容。在当代工业自动化制造中,连续性批量生产的每一个工艺都是有相应的缺陷率,单独看尽管比例不大,但相乘后却成为了企业没法提升良率的难题,而且在经过了完整性制程后再剔除残品成本费会高许多,所以,及时性检验和祛除不良品对质量控制和成本控制十分主要,也是制造产业更进一步升级的主要根基。

我认为缺陷检测没有啥难的,基本上都可以做。那为啥槽点还那么多?我认为很大一部分是AI的槽点,因为目前使用AI来做是主流,或者说只传统方法搞不定的,没办法,只有上AI的方法。AI的槽点有很多,例如:

多少人工就有多少智能,太依赖于标注的数据;过拟合严重,泛化能力差;容易被攻击到,没有提取到真正的特征;提取特征太多抽象,可解释性差,大家都是“黑盒子”玩家;经验学、尝试学,没有建立起方法论,trick太多,很多都是马后炮强行解释;“内卷”严重,nlp领域的sota 拿到CV,各种模改就work了?甚至都使用mlp进行返租现象,让我们一时半会摸不到方向。

当然,学术界和工业界也有一条巨大的鸿沟。学术界在于新,有创新点,在开源数据上各种尝试。工业界强调的是精度、成本、落地。再者场景过于分散,没办法达成一致的共识,场景、数据、需求等均是如此。单单从工业界来看,在“缺陷检测”这一个细分的场景(其实也不是啥细分场景,所有找异常的都可以叫缺陷检测)。

[Deep crisp boundaries:Fromboundariestohigher-level tasks]针对高级卷积的空间分辨率低和相邻像素的相似响应提出了CED方法。[Learning to predict crisp boundaries]认为边缘像素和非边缘像素之间的高度不平衡是导致较厚边缘的原因之一,因此提出了LPCB模型。他们将ResNeXt模块插入到编码器-解码器模型中,并引入Dice系数,使CNN无需后处理(NMS)即可产生清晰的边界。

[Deep Structural Contour Detection]提出了一种用于生成高质量边缘信息的DSCD方法。受SSIM的启发,他们提出了一种新的损失函数,并在模型中添加了一个超模块,以生成质量更好的边缘特征。

[Unmixing Convolutional Features for CrispEdge Detection]为CNN中的混合现象提出了上下文感知跟踪策略,分解边界特征以解决定位模糊问题。

受先前研究的启发,[Learning Crisp Boundaries Using Deep Refinement Networkand Adaptive Weighting Loss]提出了一种自适应加权损失函数和一个新的网络DRNet,以堆叠多个细化模块并获得更丰富的特征表示,从而实现清晰的边界信息。

新框架

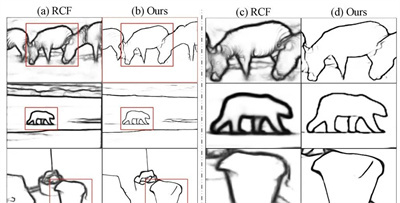

Model structure diagram

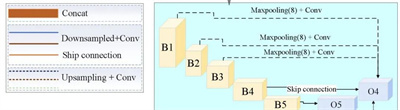

新提出的方法采用卷积编码器-解码器框架,广泛用于边缘检测。任何预训练的 CNN 模型都可以作为编码器,解码器由多层特征融合器实现,充分利用了低层边缘图中更多的位置和细节信息,以及高层特征中更鲁棒的语义信息,使得模型 可以学习到更清晰的边缘,如上图(a)所示。

提出的多特征跳过连接不仅有利于编码器和解码器之间的互连,而且在解码器内部也有连接。该模型使用每个模块的最后一层作为编码器的输出层,定义为[b1,b2,...,b5]。对于解码器部分,采用了多层特征融合机制。

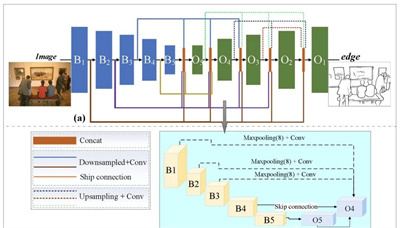

不同的输出层bi具有可以通过常规方法更新的各种大小的特征图。在这里,研究者以o4为例来解释解码器部分的构造,如下图(b)和上公式所示,其中函数C(.)表示卷积+批量归一化+ReLU激活操作。D(.)和E(.)分别表示上采样和下采样操作,[.]表示连接。B4中的特征图直接融合到O4中。

从编码器的较低层开始,首先将最大池化操作应用于B1、B2和B3中的特征图,然后将它们融合到O4中。随后,通过双线性插值获得来自解码器部分的O5。为了保持通道不变,研究者采用卷积运算来进一步统一通道数。为了更好地将低级细节和空间特征与高级语义特征融合,进一步在五个尺度特征图上进行特征融合。

Pixel-level Imbalance Learning

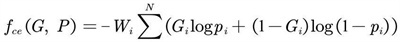

权重交叉熵。边缘图像生成可以看作是一个像素级的分类任务(边缘和非边缘像素)。它在边缘和非边缘像素的数量方面非常不平衡。

采用加权交叉熵(见上公式,其中Gi是标签,Pi是边缘预测值)来解决这样的分类任务并纠正边缘和非边缘像素之间的不平衡,可以有效地监督网络区分边缘和非边缘信息。然而,“厚度”问题仍然存在。虽然加权交叉熵可以有效地计算像素级差异,但它不能充分区分与TP边缘像素相邻的FP和FN像素值。

实验

(论文地址:https://arxiv.org/pdf/2203.09387v1.pdf)