- 02/26

- 2024

-

QQ扫一扫

-

Vision小助手

(CMVU)

摘要:针对光路中前景遮挡物影响感兴趣信息采集的问题,本文对应用相机阵列的遮挡物移除算法进行实验研究。用阵列型光场相机采集四维光场数据,然后用数字重聚焦技术进行不同深度的重聚焦,突出目标物细节特征。利用图像重构技术合成子图像阵列,选择最小误差阈值分割法标记遮挡物区域并复现原图像的细节特征。实验结果证明了应用阵列型光场相机移除遮挡物的可行性,及其改善图像质量、复现遮挡区域图像、提高图像可读性、降低噪声影响的能力。依据无参考的图像质量评价指标,本文算法在重构图像质量上SNR与PSNR分别提升了17.3%与77.6%。

关键词:光场采集;数字重聚焦;图像重构;遮挡物

引言

在计算机视觉领域中,目标物前出现遮挡与目标物出现混叠时都会对数据采集造成影响。多数传统相机设备采集数据时仅可以记录场景的二维信息,当目标物前出现遮挡时,单视角成像设备在数据采集时由于遮挡物的影响,会造成信息的大量丢失。多视角的合成孔径技术则可以同时记录空间中光线的四维信息,包括方向信息与角度信息[1],利用更高维度的信息量减少遮挡物带来的影响。相机阵列法以斯坦福大学提出的 128 台相机阵列为代表,相机采用不同的排列方式,获得多种不同角度的子图像阵列,同时利用相机阵列的景深特点,通过数字重聚焦技术与合成孔径技术可实现类似“透视”的效果[2]。相机阵列相比于传统相机多记录了两个维度的信息,为后续有效地移除遮挡物、获得高还原度的目标信息提供了理论基础。

近年来,去遮挡物算法被国内外众多学者广泛研究,并提出了具有高参考价值的理论。刘严羊硕等[3]提出一种先利用EPI的边缘特征估计景深范围,再进行光场重建的算法。此方法需要遮挡物与目标物存在明显不同的深度特性,否则影响遮挡物的识别与移除。张世辉等[4]提出一种利用随机森林检测深度图像中遮挡物的方法。其方法是基于机器学习思想,在图像检测时需要选择通用性较好的夹角特性。陈先锋等[5]提出一种基于先验信息的去遮挡物算法。该方法对遮挡区域具有低敏感度,对于非遮挡区域具有高敏感度的特性。刘润兴等[6]提出一种聚焦式光场去混叠的方法移除遮挡。此方法对图像合成有较为良好的改善,但计算量大,实时性还有待提高。Bobick等[7]提出了加入顺序约束条件的动态规划算法。该方法受限于物体的大小,无法有效处理孔状和窄物体区域。Egnal等[8]基于唯一性约束条件提出交叉验证算法,受限于唯一性约束,该方法无法使用在水平倾斜表面。

遮挡物移除算法大多着重于遮挡物移除的完全性和精确性,忽略了重构图像的质量,不利于图像细节部分的还原。本文提出一种应用相机阵列系统,基于光场数据采集与数字重聚焦技术,并通过SEEQ图像质量评价算法评估图像质量从而选择最佳的倾斜因子,并利用最小误差法分割遮挡物,最后通过图像增强与形态学处理还原完整的目标图像的方法。遮挡物移除技术在国防军事、公共安全、航天遥感等领域都有着很好的发展前景。

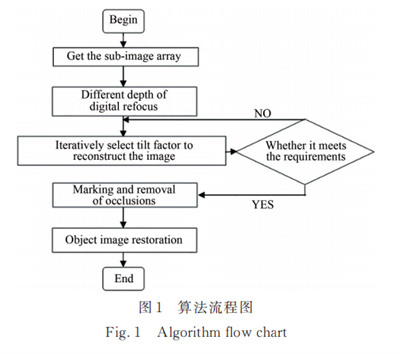

基于相机阵列的遮挡物移除算法

本文首先利用数字重聚焦技术,根据遮挡物与目标物体深度上的不同选择合适的深度重聚焦,突出目标物体细节信息。根据子图像阵列与相机阵列的位置关系,利用几何特征连续迭代选择效果最佳的倾斜因子,得到重构图像。利用最小误差法选择合理的阈值进行遮挡区域的分割。最后移除遮挡区域像素,恢复目标物图像的细节信息,具体流程如图1所示。

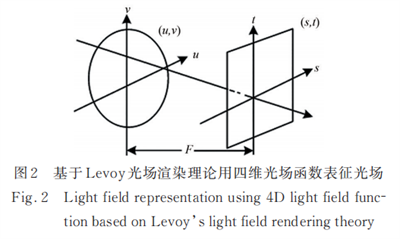

2.1光场成像与数字重聚焦

如图2所示,本文采用双平面参数法来表征光场。该方法依据Levoy等[1]提出的光场渲染理论,分别在主透镜与传感器处建立两个二维平面,设一条同时穿过两个平面的光线,分别交两个平面于(u,v)和(s,t)两点,由(u,v)和(s,t)描述这条光线的二维位置信息与二维方向信息,光线与主透镜平面和传感器平面相交的两坐标点共同构成了光场的四维函数L(u,v,s,t),其中函数值L是光线的辐射通量。

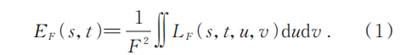

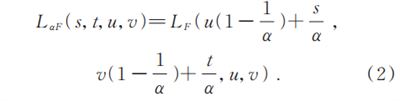

应用光场数字重聚焦技术可以做到先利用阵列相机采集信息,再根据目标物与遮挡物的深度特性进行数据重聚焦,利用相机的景深特性可以有效突出目标物的细节信息,减小障碍物带来的影响[9]。这里将光场成像系统中的光线用四维光场函数 L(u,v,s,t)表征[10],其中u-v面是光学系统主平面,s-t面是探测器所在平面,L(u,v,s,t)代表给定光线的光辐射量,下标F代表上述两平面间的距离,像面上接受到的辐射量可表示为

在此基础上,通过积分求解可以得到一幅数字图像。由于透镜平面和探测器平面定义的光场函数与透镜平面和重聚焦平面定义的光场函数之间的关系可以通过构建相似三角形的几何变换得到,四维光场函数在空间中的传播可以表示为

在这里α为两相似三角形的比例系数,调整比例系数的大小控制重聚焦的深度。

2.2倾斜因子的确定

单视角相机仅记录二维信息,在面对感兴趣区域被遮挡时具有较大的局限性[12],面对动态的目标物时可采用连续多次拍摄的方式来复现目标物,但面对目标物与遮挡物都为静态的情况,应用单视角相机移除遮挡物则十分困难。然而使用多视角合成孔径技术可以利用光场成像获得丰富的四维信息,为遮挡物的移除提供基础。通过相机阵列采集子孔径图像集,选取中心图像并使其他图形根据视差的几何关系进行平移。根据几何关系选择合适的倾斜因子重构图像,当子图像经过联合位移后,选择不同倾斜因子的状态会有所不同,导致重构图像轮廓不清晰。

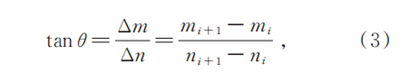

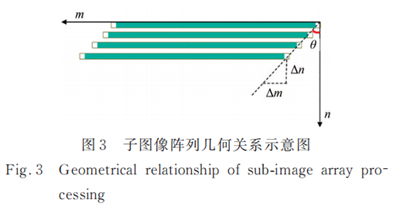

如图3所示,本文假设同一排阵列相机镜头间距为Δm,其中第i的相机相对坐标原点的位置为mi并建立坐标系表征倾斜因子,根据几何关系有

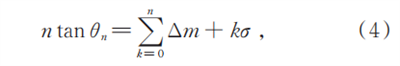

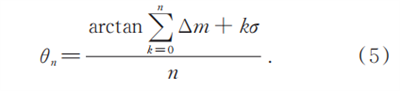

其中:θ为倾斜因子,Δθ为两图像沿n轴方向的间距,这里定义则有Δn=1,tanθn=Δm。

其中:σ为修正因子,本文中取σ=0.008多次迭代寻找重构效果最好的倾斜因子。

2.3图像重构及其质量分析

刘利雄等[11]提出了一个有效的通用无参考(NR)图像质量评估(IQA)模型,该模型利用畸变图像的局部空间和光谱熵特征。采用一个基于失真分类和质量评估的两阶段框架,利用支持向量机(SVM)训练图像失真和质量预测引擎。被称为基于空间光谱熵的质量指数(SSEQ),能够跨多个失真类别评估失真图像的质量。其中空间熵为

其中:x是块内的像素值,p(x)为经验概率密度。失真的引入会导致空间熵的变化,噪声导致局部空间熵的降低,通过研究空间熵的变化特征可以反应出图像扭曲的类型。该模型利用下采样响应作为输入,从输入中提取12维局部熵特征向量,并从这些特征中学习预测图像质量分数。

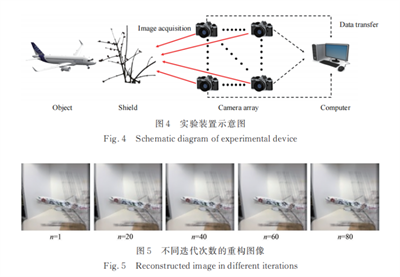

按照如图4所示的装置图进行数据采集,该实验选择室内场景拍摄目标物飞机模型,遮挡物为树枝,构建10×10的相机阵列,单次拍摄采集不同角度及不同位置子图像100张。如图5所示,本文选择子图像阵列中一行图像进行图像重构,以第5张图像为中心其余图像分别向两侧平移。利用修正因子进行多次迭代,每次迭代后应用SEEQ图像质量评估模型进行质量评估,从而确定最适合此相机阵列的倾斜因子。观察重构图像,虽然重构后遮挡范围变大,但经过加权平均后,原被遮挡物完全覆盖住的部分已经被很好地复现与还原。

2.4遮挡物区域标记

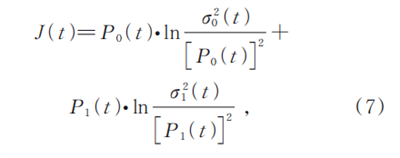

在计算机视觉中,图像分割一直是一个热门的研究方向,同时也是多数图像处理问题的关键步骤。其中经典的阈值分割算法有最小误差法、最大熵法和最大类间方差法[12-14]等,本文应用的是龙建武等提出的一种自适应最小误差阈值分割算法[19]。假设转换为灰度图像后由暗遮挡物和亮目标物组成,且遮挡物与目标物满足高斯分布。其中,P0和P1分别为遮挡物C0和C1各自分布的先验概率,且C0C1各自分布均服从均值为μj和方差为σJ2的正态分布,则有

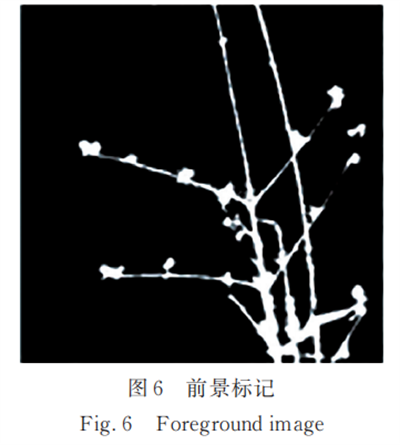

其中:J(t)为最小误差函数,最佳阈值在其取最小值时获得。图6所示为利用最小误差阈值分割法,经过图像增强、形态学处理后得到的遮挡物标记图像。

2.5遮挡物区域移除与还原

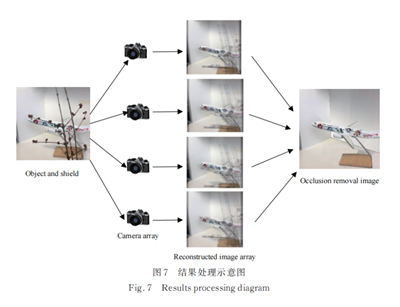

如图7所示,应用相机阵列采集数据后进行图像重构,移除目标图像前被标记的图像,并用重构图像进行还原。按本文2.3节所提出的重构方式得到的重构图像整体质量不高,因为我们只考虑了感兴趣区域的重构质量。本文将2.4节所标记的前景区域作为重点,只保留此区域重构质量优秀的图像组成新的子图像阵列,提取相机阵列中心相机所拍摄的图像并标记前景区域。同时保留未被标记区域的全部元素,只对被遮挡区域进行计算,本文提出的方法只对遮挡区域进行相关计算,在最大程度上保证了图像质量。将感兴趣区域中每一个像素点进行替换,得到遮挡物移除后的重构图像。

实验结果分析

本文实验所使用的相机阵列中单相机型号为Canon EOS 6D型,搭载了一个2020万像素的CMOS感光组件与DIGIC5+图像处理器核心,图像感应器尺寸为35.8mm×23.9mm,采集图像最大尺寸为5472×3648。镜头型号为EF24~105mmf/4。

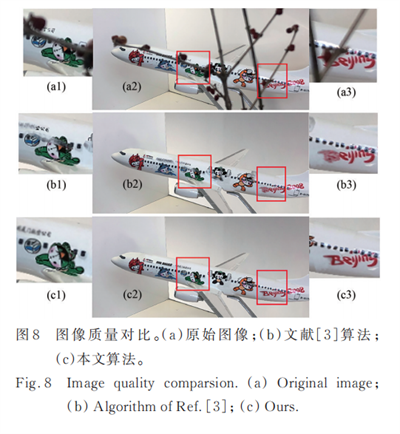

如图8所示,本文提出的应用阵列型相机实现遮挡物移除的方法,对于不涉及目标物细节处的图像有较强的移除遮挡物的能力,并在移除后不会造成明显的图像重影与分辨率丢失。对于目标物细节处的还原,利用基于相机阵列采集的大量数据有较强的还原细节能力。图8(a)为未处理的原始图像,部分细节信息完全被遮住且无法辨认。图8(b)为文献[3]所提出的算法经处理后则可以复现被遮挡部分细节信息,使得字体可以辨认,但重构图像较为模糊,部分细节无法辨认。图8(c)为本文提出的遮挡物移除算法,通过合理的倾斜因子选择很好地根据几何关系消除了图像的扭曲,同时还原了图像的细节信息,保证了图像质量。

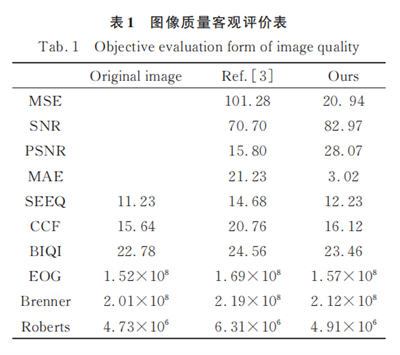

如表1所示,为证实本文所提出算法的优势,本文选取有参考的客观评价指标MSE、SNR、PSNR、MAE进行比较。在数值上,本文算法的MSE与MAE均小于文献[3]的结果,在SNR与PSNR上分别提升了17.3%与77.6%。实验证实了本文提出的算法在细节的还原度上优于其他算法,同时有效提升的重构图像的信噪比。为了应对实际应用中无参考图像的情况,我们对比了6组无参考的评级指标,分别为EOG、Brenner、Robters算子与刘利雄等提出的基于空间光谱熵的质量评价方法(SSEQ),Wang等提出的无参考的彩色图像质量评价方法(CCF)[16]以及Anush Krishna Moorthy等提出的构造盲图像质量指数的两步框架(BIQI)[18]方法对3幅图像进行质量评价。其中分数区间为0~50,0分为质量最佳。对比10种客观评价标准,本文算法相对文献[3]在细节复现与图像质量上都有明显改善,获得了轮廓清晰、可信度高的重构图像。

此外,同时采集图像与光场数据的方案很好地解决了目标物或遮挡物为动态物体的情况,但是应用阵列型光场相机的遮挡物移除算法需要反复计算得到最佳的倾斜因子,这种方法的计算量较大,无法做到实时移除遮挡物。

结论

本文提出一种应用阵列型光场相机的遮挡物移除算法。实验结果证明该方法与文献[3]提出的前景移除算法相比,不需要目标物与遮挡物之间存在较为明显的深度区别,而且仅对遮挡区域进行计算,减少了图像重构导致未被遮挡区域的像素损失。本算法应用范围更广,实用性更强。在图像重构中选择合理的倾斜因子,可以有效降低目标区域的模糊与噪声的引入,细节上目标物边缘轮廓也有较为明显的改善。依据无参考的图像质量评价指标,本文算法在重构图像质量上SNR与PSNR分别提升了17.3%与77.6%。本文提出的算法仍具有一定的局限性,在遮挡物分割方面采用最小误差的阈值分割法,面对目标物与遮挡物灰度范围较为接近有可能产生分割区域不准确而过度复现原图导致图像模糊的现象,今后将针对上述问题做进一步研究。

参考文献:

[1]LEVOY MH,ANRAHAN P. Light field rendering[C]//Proceedings of the 23rd Annual Conference on Computer Graphics and Interactive Techniques. New Orleans:ACM,1996:31-42.

[2]WILBURN B,JOSHI N,VAISH V,et al. High performance imaging using large camera arrays[J]. ACM Transactions on Graphics,2005,24(3):765-776.

[3]刘严羊硕,刘宾,潘晋孝基于前景移除的合成孔径成像算法[J]光学学报,2018,38(6):0611002.LIU Y Y S,LIU B,PAN J X. Synthetic aperture imaging algorithm via foreground removing[J]. Acta Optica Sinica,2018,38(6):0611002.(in Chinese)

[4]张世辉,刘建新,孔令富.基于深度图像利用随机森林实现遮挡检测[J].光学学报,2014,34(9):0915003.ZHANG S H,LIU J X,KONG L F. Using random forest for occlusion detection based on depth image[J]. ActaOptica Sinica,2014,34(9):0915003.(in Chinese)

[5]陈先锋,郭正华,伍俊龙,等.基于区域先验信息的去遮挡立体匹配算法[J].激光与光电子学进展,2019,56(19):191001.CHEN X F,GUO Z H,WU J L,et al. De-occlusion stereo matching algorithm based on regional prior informa⁃tion[J]. Laser & Optoelectronics Progress,2019,56(19):191001.(in Chinese)

[6]刘润兴,任明俊,肖高博.一种聚焦式光场成像去混叠方法[J]光学学报,2018,38(6):0611001.LIU R X,REN M J,XIAO G B. A method of eliminating artifacts in focused light field imagin[J].ActaOptica Sinica,2018,38(6):0611001.(in Chinese)

[7]BOBICK A F,INTILLE S S. Large occlusion stereo[J]. International Journal of Computer Vision,1999,33(3):181-200.

[8]EGNAL G,WILDES R P. Detecting binocular half-occlusions:empirical comparisons of four approaches[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Hilton Head:IEEE,2000:466-473.

[9]张春萍,王庆.光场相机成像模型及参数标定方法综述[J].中国激光,2016,43(6):0609004.ZHANG C P,WANG Q. Survey on imaging model and calibration of light field camera[J]. Chinese Journal of Lasers,2016,43(6):0609004.(in Chinese)

[10]聂云峰,相里斌,周志良.光场成像技术进展[J].中国科学院研究生院学报,2011,28(5):563-572.NIE Y F,XIANG L B,ZHOU Z L. Advances in light field photography technique[J]. Journal of the Graduate School of the Chinese Academy of Sciences,2011,28(5):563-572.(in Chinese)

[11]LIU L X,LIU B,HUANG H,et al. No-reference image quality assessment based on spatial and spectral entropies[J]. Signal Processing:Image Communication,2014,29(8):856-863.

[12]KITTLER J,ILLINGWORTH J. Minimum error thresholding[J]. Pattern Recognition,1986,19(1):41-47.

[13]KAPUR J N,SAHOO P K,WONG A K. A new method for grey-level picture thresholding using the entropy of the histogram[J]. Computer Vision,Graphics and Image Processing,1985,29(3):273-285.

[14]OTSU N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems,Man,and Cybernetics,1979,9(1):62-66.

[15]龙建武,申铉京,陈海鹏.自适应最小误差阈值分割算法[J]. 自动化学报,2012,38(7):1134-1144.LONG J L,SHEN X J,CHEN H P. Adaptive minimum error thresholding algorithm[J].Acta Automatica Sinica,2012,38(7):1134-1144.(in Chinese)

[16]WANG Y,LIN,LIZY,etal.An imaging-inspired no-reference underwater color image quality assessment metric[J]. Computers & Electrical Engineering,2018,70:904-913.

[17] MOORTHY A K,BOVIK A C. A two-step framework for constructing blind image quality indices[J]. IEEE Signal Processing Letters,2010,17(5):513-516.

(文章来源于期刊《液晶与显示》 ,如有侵权,请联系删文)