- 07/11

- 2025

-

QQ扫一扫

-

Vision小助手

(CMVU)

摘要:高速成像技术在物理、化学、生物医学、材料科学及工业等众多领域扮演着十分重要的角色。受电荷存储和读取速度的限制,基于电子成像器件的数码相机成像速度难以进一步提高。近年来,随着成像新技术的发展,超高速和极高速光学成像的性能已得到显著提升,具备更高的时间分辨率、空间分辨率及更大的序列深度等。介绍高速成像技术的发展历程,根据成像方式,将近年来具有代表性的新型超高速和极高速光学成像技术分为直接成像和编码计算成像两个类别。分别介绍和讨论各种新型超高速和极高速光学成像技术的概念和原理,并比较各自的优缺点。最后,对这一领域的发展趋势和前景进行展望。本文旨在帮助研究者系统了解超高速和极高速光学成像技术的基本知识、最新研究发展趋势和潜在应用,为该领域科学研究提供参考。

关键词:高速成像;超高速成像;极高速成像;时间分辨率;空间分辨率;序列深度

1引言

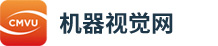

受生理结构的限制,人眼在观察高速运动物体和瞬态过程时具有一定的局限性(人眼的时间分辨率仅为1/24s左右),而高速成像技术能够以高的成像速度和时间分辨率捕获人眼无法观测到的细节和动态变化,帮助人类更好地理解和探索自然界和科学领域的复杂性。高速成像技术在物理、化学、生物医学、材料科学、工业制造、流体力学、爆炸与冲击研究等领域[1-8]发挥着重要的作用。自1826年法国人尼埃普斯(Niépce,1765—1833)利用日光摄影法拍摄了人类第一张照片以来[9],摄影技术便走进了人类历史的舞台。如何拍摄高速运动的物体一直是摄影师们追求的目标。人们对高速成像的兴趣最早可以追溯到1878年,英国摄影家迈布里奇(Muybridge,1830—1904)用多台胶片相机连续曝光拍摄了一匹奔驰的马[10],根据实验数据平息了关于马在奔跑时4只马蹄是否同时离开地面的争论,如图1(a)所示。另一个著名的高速成像实验由德国物理学家马赫(Mach,1838—1916)在1887年完成[11],他拍摄了一张子弹超音速飞行的照片,为之后研究空气动力学做出了重要贡献,如图1(b)所示。随后,被誉为高速摄影之父的埃杰顿(Edgerton,1903—1990)于1930年代发明了电子频闪技术[12],这使得相机的曝光时间精确到微秒量级,定格了许多精彩瞬间,比如图1(c)所示的蜂鸟飞行的瞬间[13]和图1(d)所示的牛奶滴落飞溅刹那形成的“牛奶皇冠”[13]。

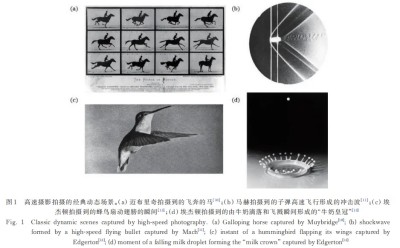

随着对成像速度需求的不断提高,机械转镜技术于20世纪50年代被应用于高速成像的研究中。Miller[14]设计的第一台高速转镜相机能够以106frame/s的成像速度记录核爆炸瞬间的演化过程。但是,这种类型的相机受到机械转镜旋转速度的限制,成像速度无法再进一步提高。20世纪60年代末期,美国贝尔实验室发明了电荷耦合器件(CCD)后,高速成像技术便从胶片记录相机逐步迈入了数码相机的时代。国际按照帧速率对高速成像速度进行了划分,从已有的定义延伸出来[1,15]:当成像速度大于103frame/s(对应的帧间隔时间为1ms),便可称为高速成像(HSI);当成像速度大于107frame/s(对应的帧间隔时间为100ns),可称为超高速成像(UHSI);成像速度大于1012frame/s(对应的帧间隔时间为1ps),可称为极高速成像(EHSI)。截止目前,一些基于电子成像器件的高速相机的成像速度已经达到了超高速成像级别的水平[16-17]。但是,受到数字化带宽和数据传输速度的限制[18],成像速度难以继续突破。然而,超快现象广泛存在于物理、化学、生物医学等基础科研领域中,如植物的光合作用过程[19]、细胞分子动力学过程[20]、超短激光脉冲产生[21-22]、强光与物质相互作用[23]等,发生的时间多在纳秒、皮秒、飞秒甚至阿秒量级范围内。显然,基于电子成像器件的高速成像技术观测小于百纳秒量级的超快现象和过程受到了限制。

近年来,伴随超快激光器技术和计算机数据处理能力的突飞猛进,阿秒激光、编码成像、深度学习、光场调控、压缩感知、数字全息等光、电信息处理技术得以长足发展[24-35]。在此背景下,光学成像系统不再仅仅依赖机械转镜和高帧率图像传感器,一些具有新型成像模式的超高速成像技术不断涌现出来。例如,基于飞秒脉冲的频谱分离对目标完成多次曝光的直接成像方式[36],或先对目标进行编码和采样最后通过算法进行重建的成像方式[37]。新的成像方法与技术为突破传统高速成像中的诸多限制因素提供了新的思路。截止目前,一些代表性的新型高速成像技术的成像速度最快可达1013frame/s以上[38-40],达到了极高速成像的水平,相对应的时间分辨率达到百飞秒量级。

国内外许多著名大学和科研机构纷纷开展了关于新型超高速和极高速光学成像技术及其应用的研究,如日本东京大学[36,41-42]、日本庆应义塾大学[43-44]、美国加州理工学院[37-39,45-46]、加拿大魁北克大学国立科学研究院[47-49]、瑞典隆德大学[50]、美国得克萨斯大学奥斯汀分校[51]、中国科学院西安光学精密机械研究所[52]、华东师范大学[53-58]、深圳大学[40,59-60]、西安交通大学[61]、武汉大学[62-63]、西湖大学[64-65]等都开展了各具特色的研究工作。图2描绘了近一百年来从高速成像逐渐发展到超高速成像,再进一步到极高速成像的代表性技术的历史发展路线。

本文旨在帮助研究者们了解近年来光学领域内一些具有代表性的超高速和极高速光学成像技术和它们的发展趋势,为该领域的研究人员提供参考。介绍高速成像技术的发展历程和目前所面临的技术问题,如提高时间分辨率与空间分辨率、增大序列深度、提高算法准确性和成像质量等,重点介绍新兴超高速和极高速成像技术的新原理、新思路和新方法;将具有代表性的超高速和极高速成像技术分为两种类型,即直接成像技术和编码计算成像技术。介绍每类方法中的代表性技术的关键概念和工作原理,特别是它们如何打破传统方法,突破成像速度和快门曝光时间方面的限制。最后,对本文内容进行总结和展望。鉴于该领域发展非常迅速,不可能包含所有的相关工作,只能选择一些具有代表性的关键技术进行论述,难免会有所遗漏。

2 代表性超高速和极高速光学成像技术

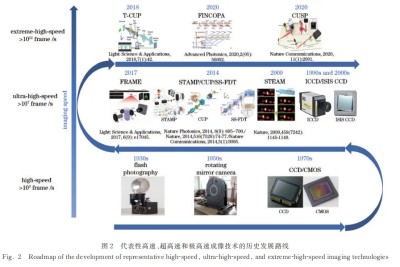

将超高速和极高速光学成像技术按照成像方式的差异分为两个大类,即直接超高速和极高速成像、编码计算超高速和极高速成像,如图3所示。直接超高速和极高速成像是光学系统通过短暂曝光就可直接将探测器捕获的物体光强信息转换为图像的过程,即只须对探测器信号进行简单的数据处理就可以得到想要的高帧率图像。而编码计算超高速和极高速成像则是一种不同的成像方式,它在成像系统中引入编码模式,将高速事件信息编码为单一图像或图像序列,最后通过计算解码得到重建成像,可实现对快速变化场景更高时间分辨率的捕捉。这种技术能够减少数据传输的需求,但同时也需要特定的编码、解码算法和硬件支持。

此外,这两类在具体成像系统的光路设计方面也具有一定的区别。比如,直接超高速和极高速成像技术在捕获时序图像信息时通常需要进行空间分离,以记录不同时刻的动态序列图像,但光路中往往存在多种类型和大量的分光元件,操作相对繁琐。相比之下,编码计算超高速和极高速成像技术通过将时序图像信息编码压缩到单幅图像中,然后再利用算法重建出多幅原始动态场景信息,尽管在图像重建过程可能引入图像误差和降低图像质量,但该成像方式可以简化光路并提供更高效的数据处理方法。

2.1直接超高速和极高速成像技术

直接超高速和极高速成像技术是高速成像领域中的一个重要方向,它们采用直接成像的方式,记录目标在极短时间内的光学信号来实现高速成像。在这方面,基于固体成像器件的高速相机和新兴的成像技术,如顺序时间放大成像技术、顺序全光映射超高速成像技术、非线性光参量放大的分幅成像技术,引领着这一领域的发展。这些技术通常使用超快激光光源和高灵敏度的探测器,以纳秒、皮秒甚至飞秒级别的时间分辨率记录物体的瞬时状态,优势是成像的空间分辨率高。

2.1.1基于固体成像器件的超高速成像

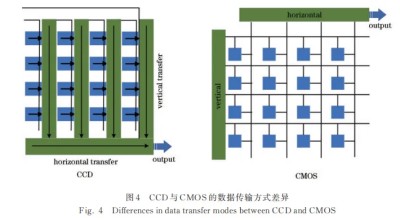

互补金属氧化物半导体(CMOS)和电荷耦合器件(CCD)是当下普遍被采用的两种图像传感器,分别发明于1963年和1969年[66-67]。CCD与CMOS的主要区别在于电荷数据传送方式的不同。如图4所示,在CCD结构中,每次曝光时,每一行中每个像素的电荷数据会依次传输到下一个像素中,最终从底端输出,并通过传感器边缘的放大器得到放大输出。相比之下,在CMOS结构中,每个像素旁边都配备了放大器和A/D转换电路,以一种类似内存电路的方式输出数据。因此,这两种结构在图像噪声和成像质量等方面具有不同的表现。随着半导体器件与电子技术的不断更新,基于这两种固体成像器件的数码相机大大推动了高速成像技术的发展。由于具有较高的技术成熟度,各种商业高速数码相机已成功应用于许多领域,比如该类相机具备在1920×1080像素分辨率下每秒获得1000~3000帧图像的成像能力,这使得它们在体育、广告和科学纪录片中非常受欢迎。但是,如果追求更高的成像速度,就需要以降低分辨率为代价,一定程度上限制了该类相机的应用场景。例如,典型的高端商业相机Phantom-TMX7510[68]的最大成像速度为1.75×106frame/s@1280×32pixel。显然,传统并行读出电荷的方法难以达到107frame/s及更高的成像速度[18,69],必须另辟新径。目前追求每秒千万帧(>107frame/s)及以上成像速度的代表性固体成像器件大致有3种:像增强型ICCD、具有原位存储图像传感器(ISIS)结构的CCD、具备特殊存储架构的CMOS。

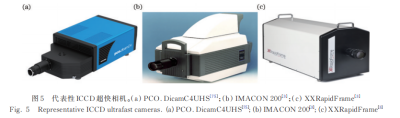

ICCD型相机采用微通道板(MCP)图像增强器,于20世纪90年代被开发出来[70-71]。MCP图像增强器的主要功能是对入射光子进行倍增,即对入射光信号进行放大,它使ICCD相机能够在极低的光照条件下或在极短的曝光时间下拍摄图像,非常适合对高速弱光目标的探测[72-74],但一次拍摄获取的帧数比较少,且多个图像增强器的存在也会增加图像中的噪声水平。该类相机的典型代表如图5所示:德国PCO公司研制的四通道像增强器高速相机PCO.DicamC4UHS[75],如图5(a)所示,可以108frame/s的成像速度连续获取4帧图像;英国Hadland公司发布的高速相机IMACON200[3],如图5(b)所示,采用了8个通道MCP-CCD,可实现以2×108frame/s的成像速度连续记录8帧图像;美国StanfordComputerOptics公司研制的XXRapidFrame型高速分幅相机[3],如图5(c)所示,能够以等效1011frame/s的成像速度拍摄8张图像。但是,由于分光路的原因,它们对光强要求比较苛刻,很难用于显微成像领域。

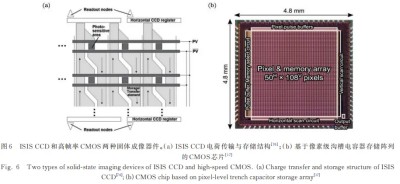

另一类获取超高速成像的固体成像器件是基于ISIS结构的CCD。2005年,Lazovsky等[76]采用新型的电荷传输和存储结构,设计的新型探测器实现了108frame/s的成像速度,一次可获取16帧图像@64×64pixel。其工作原理如图6(a)所示,每个像素由1个感光区域、2个读出门(PV和PV)和16个存储单元(分为2组,每组8个元素,传输方向相反)组成。在垂直方向上,相邻像素的传输元素构成了连续的两相CCD寄存器。在传感器的顶部和底部分布着带有多端口读出节点的水平CCD寄存器,在每帧10ns的曝光时间内(对应的成像速度为108frame/s),两个读出门在触发模式下异相运行,交替地将光生电荷传输到上下两组存储元件中。在图像采集过程中,奇数帧或偶数帧产生的电荷将两边的存储单元填满而不被读出,这是其速度的瓶颈。与CCD器件相比,CMOS相机的高成像速度依赖于单个传感器的灵敏度和数据传输速率,而不是芯片的数量,提高其成像性能的关键是升级像素的结构和相关电路。2020年,Suzuki等[17]研制出一种基于像素级沟槽电容器存储阵列的超高速和极高速全局快门CMOS相机,如图6(b)所示,它的帧率可以达108frame/s@50×108pixel,结合目前研究进展,应该是当下最快的CMOS成像器件之一。

如何把固体成像器件用于超高速和极高速成像一直是人们探索的课题,尽管它们在电子学技术上已取得了一定的进步,但是成像速度依然受到电子瓶颈(电荷读取和电荷存储速度)的制约,难以超越1011frame/s。

2.1.2顺序时间放大成像技术

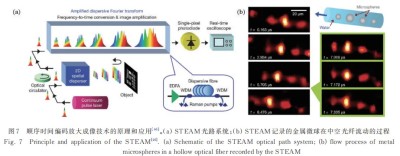

2009年,Goda等[46]提出了顺序时间放大成像技术,简称STEAM,该技术采用单像素光电探测器捕获整个二维图像,并实现了25dB的光学图像增益。其光路系统如图7(a)所示,采用锁模飞秒激光器作为光源。一束宽脉冲激光进入二维色散器后被映射为二维光谱带,随之不同频率分量的光照亮目标物体;物体的空间轮廓信息被编码在反射的二维光谱带中,载有编码信息的信号返回色散器被重新组合为宽脉冲,随后进入到傅里叶变换器中;最后,编码图像的脉冲频谱被转换为相应的时间波形信号,利用单像素探测器对其探测并放大和成像。该技术最快可以实现107frame/s的成像速度,相比传统的工业相机,提高了约1万倍,对捕捉非重复信号具有重要的意义。STEAM成像速度的快慢取决于激光脉冲的重复频率,非常适合于空间分辨率在几十微米的快速监测成像。如图7(b)所示,STEAM被用于监测悬浮金属微球在中空光纤中流动的过程,微球以2.4m/s的速度从右向左流动,拍摄图像的帧间隔为163ns(对应成像速度6.1×106frame/s),曝光时间为440ps。其中光纤内径为50µm,微球直径为10~30µm,像元尺寸为6.4µm×0.3µm,成像视场为170µm×27µm。由于采用的是单像素探测器,所以采集的图像空间分辨率比较低,大约10µm左右。此外,每一帧的图像分辨率较低,水平和垂直方向上只有几十个像素。

2.1.3顺序全光映射成像技术

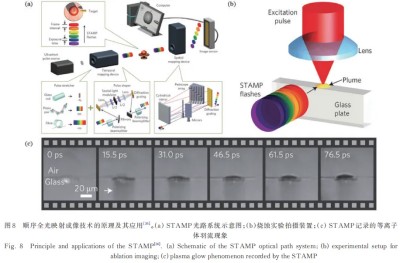

2014年,Nakagawa等[36]提出了一种基于顺序全光映射的超高速成像技术,简称STAMP,其系统光路如图8(a)所示。该系统主要分为4个部分:超短激光源、时间映射装置(TMD)、空间映射装置(SMD)和图像传感器。首先,激光光源产生的一束超短脉冲进入时间映射装置得到展宽,随即被分割成一系列不同频谱的子脉冲串,脉冲串按照不同频率顺序在时间上前后排布;随后,脉冲串入射到目标上完成连续曝光,利用一个空间映射装置将携有图像编码信息的子脉冲串在空间上分离,最后光束投射到传感器的不同区域。基于该技术的成像系统实现了最小229fs的帧间隔,对应最大成像速度可达4.4×1012frame/s,同时曝光时间设置为733fs,一次拍摄可获得6帧图像@450×450pixel,空间分辨率可以达到~10µm以内。STAMP的成像速度取决于脉冲频谱的离散程度,可以通过改变时间映射装置中的时间色散来调节。该技术的一个典型应用如图8(b)和图8(c)所示,STAMP被用于激光烧蚀现象的观测实验,成功记录了等离子体灯丝的自由电子产生过程和激光照射产生的等离子体羽流超快现象。该实验中,使用聚焦飞秒脉冲激光(脉冲能量为100µJ,脉冲宽度为70fs)烧蚀玻璃板表面。在透射模式下用STAMP成像系统观察超快现象,其中所拍摄图像帧间隔为15.5ps(对应成像速度为6.4×1010frame/s),曝光时间为13.8ps,每帧图像分辨率达470×470pixel。

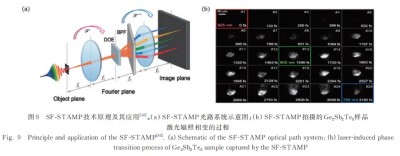

虽然STAMP超高速成像技术具备较强的单次多幅成像性能,可用于皮秒时间尺度的一些超快事件探测,但序列深度只有6帧,对于一些超快的瞬态现象显然还不够。2017年,Suzuki等[43]基于STAMP的研究基础,提出了利用光谱滤波的顺序全光映射成像技术(SF-STAMP),它可以一次获取25帧图像,相比STAMP,序列深度增加了将近4倍。SF-STAMP放弃了STAMP中时间映射装置的脉冲整形操作,不再使用几个时间离散的探测脉冲,而使用一个啁啾脉冲来探测瞬态事件。具体光路系统如图9(a)所示,啁啾探测脉冲经第一个透镜得到傅里叶变换,随后被放置在傅里叶平面上的衍射光学元件(DOE)整形,形成多个阵列光束。倾斜放置的带通滤波器(BPF)可以使阵列光束以不同角度入射,从而出射具有不同透射波长的窄带光束。携带瞬时信息的多个窄带光束再经第二个透镜得到傅里叶逆变换,最后由探测器采集。该成像系统的序列深度等于DOE产生的阵列光束数量,所以增加帧数相对容易,而成像速度则取决于探测脉冲的啁啾率和出射光束的波长间隔。如图9(b)所示,SF-STAMP以超过7.52×1012frame/s的成像速度记录了飞秒激光辐照Ge2Sb2Te5样品后从晶体到非晶体相变的演化过程,一次拍摄可获得25帧图像@400×300pixel。泵浦激光辐照后,从图9(b)中可以明显观察到相变过程发生在665fs左右,样品表面随后出现较亮的非晶态表现,验证了Ge原子从八面体位置到四面体位置的理论模型。尽管SF-STAMP提高了序列深度,但由于序列深度与单帧像素数之间的制约关系,使用衍射光束多的DOE要同时搭配更大尺寸、更多像素数的传感器来进行图像采集。2023年,武汉大学Li等[62]设计了一种基于二维频谱切片的顺序全光映射成像技术,该技术允许以二维方式同时分离和排列帧的序列,有助于充分利用光学元件的工作区域。与SF-STAMP相比,其具有更高的功率效率,一次拍摄也可以捕获25张图像,可实现成像速度为2.5×1012frame/s、空间分辨率接近2.46µm的成像水平。

2.1.4基于倾斜微透镜阵列的条纹相机

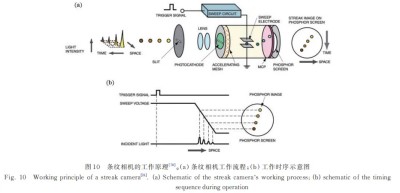

2014年,Heshmat等[77]利用倾斜微透镜阵列和条纹相机组成的光路系统实现了二维超高速成像,该成像方式简称TLA-SC。条纹相机是一种具备超高时间分辨率的探测器,也称变像管扫描相机。条纹相机的基本工作原理如图10(a)所示,条纹相机主要由狭缝、光学元件部分、光阴极、条纹变像管和荧光屏组成。入射光信息首先进入最前面的狭缝,之后经过前端光学系统到达条纹管的光阴极上转换为电子,电子被加速进入到扫描板。拍摄时,条纹管中加载横向(电子从上到下扫描)的扫描电压,同时电子进入MCP时会被倍增数千次,如图10(b)所示。该电压随时间线性变化,不同时刻的电子受到的横向电场力不同,所以不同时刻的电子打在荧光屏上的位置不同,最早的光脉冲相对应的荧光图像在最上方,其他图像从上到下依次排列,不同时刻的入射光由荧光屏上垂直坐标的位置来区分。同时,荧光屏的亮度与入射光强度成正比,荧光屏水平方向上的位置对应入射光入射的水平位置。至此,4个光脉冲的时间、强度以及空间信息均得到测量和显示。遗憾的是,条纹相机只具备一维成像的能力。

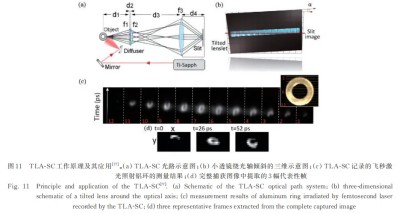

为了实现二维成像,TLA-SC在光路中设置了一个倾斜的微透镜阵列,详细的光路如图11(a)所示。其中f1为微透镜阵列,由于它是倾斜放置的,所以每个透镜所生产的像的高度位置是不同的,而且只有透过前方狭缝的横条部分区域才能进入条纹相机中。f2和f3组成的中继透镜组可以将目标在不同高度上的信息投射到条纹相机的入口狭缝上,从而将目标的水平和垂直信息记录在单一的、多路条纹图像中。最后将不同微透镜对应的子图像组合在一起,就可以获得一张完整的场景时空动态图像。图11(b)为TLA-SC以5×1011frame/s的成像速度记录的飞秒激光脉冲照明铝环的瞬间图像,相对应的时间分辨率达2ps。该成像光路的成像速度取决于条纹相机的扫描速度,但是由于需要通过很窄的入口狭缝成像,如图11(c)和图11(d)所示,采集到的图像光吞吐量严重缺失,导致每帧图像的像素数非常少,成像质量比较差。

2.1.5非线性光参量放大的分幅成像技术

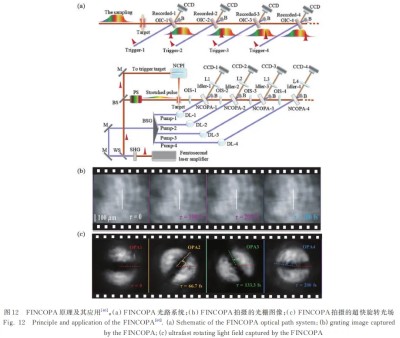

2020年,Zeng等[40]基于光参量放大技术,提出了非线性光参量放大的分幅成像技术(FINCOPA)。工作原理如图12(a)所示,该光路系统由4组OPA、4台CCD相机和4种不同的泵浦激光器的延迟线共同组成。非共线的OPA允许泵浦光、信号光和闲频光沿不同方向传播,因此可以在几乎不受其他干扰的情况下记录信号或图像。OPA可将瞬态场景的时间帧转换为空间上分离的图像,4组OPA可在极短的时间内连续记录4帧图像。首先,采用一束长脉宽的飞秒采样脉冲覆盖瞬态过程中的所有信息。然后,利用4组级联的OPA(即OIS-1、2、3和4)和1串超短脉冲序列(Pump-1、2、3和4)触发和切换来自采样脉冲的不同时间切片的成像信息到另一串闲频光序列(Idler-1、2、3和4)上。由于被记录的图像在空间上是相互分离的,所以它们可以被不同的CCD相机接收。

如图12b)所示,在一个以激光诱导空气等离子体光栅为目标的实验中,FINCOPA获得了50fs时间分辨率的光学成像,空间分辨率大约83lp/mm,成像速度达1013frame/s。图12(c)为FINCOPA以66.7fs帧间隔拍摄的超快旋转光场图像,记录了旋转速度为13.5×1012rad/s的极快涡旋光学晶格的动态过程,最大成像速度达1.5×1013frame/s[79],达到了极高速成像水平。FINCOPA成像系统的帧间隔时间由采样脉冲和触发脉冲之间的延迟时间决定,空间分辨率取决于OPA的空间带宽,而图像的时间分辨率由触发脉冲的持续时间决定。与其他超高速成像技术相比,FINCOPA一次拍摄只能获取4帧图像,序列深度还有待提高。但是,每增加一帧图像,就需要增加额外的探测光路,光学元件数量就会越多,系统就会庞大和繁琐。

以上这些直接超高速和极高速成像技术展现了在不同光学原理和器件基础上的创新,为捕捉超快速度和瞬态现象提供了独特的解决方案。其中以固体成像器件为代表的高速商业相机在高速成像领域取得了显著进展。未来需要通过优化固体成像器件结构,提高光敏性和数据传输速率,进一步拓展应用领域,并继续提高成像速度。STEAM通过顺序时间编码实现了超高速成像,将来有望通过优化激光脉冲重复频率提高成像速度,满足更广泛的瞬态现象监测需求。STAMP和FINCOPA未来的研究可侧重于提高序列深度,同时保持超高速成像性能,以更全面地捕捉复杂瞬态事件过程。TLA-SC可以往提高图像的光吞吐量的方向发展,以改善图像质量。综合而言,可以期待这些技术在更多应用场景中发挥更大作用,这些技术为深入理解瞬态现象和超快过程提供更为清晰的视觉呈现。提高序列深度和图像质量、广泛拓展应用领域将是这些技术发展的重要方向。

2.2编码计算超高速和极高速成像技术

编码计算超高速和极高速成像技术是一种创新性的成像方法,通过利用特殊的编码和计算策略,实现对极短时间内发生的高速过程的记录和重建。这种技术主要分为两个阶段:编码和计算重建。编码阶段,目标物体被赋予一种特殊的编码,这种编码可以是空域的,也可以是频域的。编码后的图像数据需要通过专门设计的算法进行处理和计算。这些算法能够解码编码信息,并还原目标物体在极短时间内的真实状态。计算重建阶段的复杂度和精确度直接影响了最终成像的质量和准确性。其中,单次频域层析成像技术、压缩超快成像技术、基于多重曝光的频率识别算法成像技术等是这一类编码计算超高速和极高速成像技术的代表。它们在记录超快现象的同时,通过计算成像的方法控制系统的点扩展函数和全面校正图像像差等,充分发挥编码和计算的优势,实现更好的成像质量、更高的图像分辨率、更大的序列深度等。

2.2.1单次频域层析成像技术

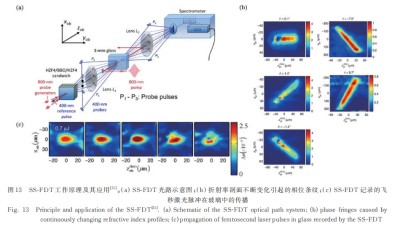

2014年,Li等[51]提出了单次频域层析成像技术,简称SS-FDT,该成像方法从不同角度的干涉图像编码重建出不同的时间信息,用于监测折射率的瞬态变化过程。详细的光路系统设置如图13(a)所示。一束波长为800nm的飞秒脉冲激光在融石英玻璃中诱导了一个非线性折射率依赖的等离子体,并引起了折射率瞬态的结构变化,这种变化以光速发生;随后,从泵浦脉冲直接分离的一对脉冲交叉射入由两个HZF4玻璃和BBO晶体组成的三层结构,产生了一组啁啾、倍频的400nm探测脉冲阵列。在原实验中,产生了5个不同角度分离的检测脉冲,它们经透镜L1在目标处时空叠加,对于每个子脉冲,从不同角度记录折射率结构的相位条纹,即编码过程。然后,透镜L2将检测脉冲直接成像到光谱仪中,与另一个400nm的参考脉冲干涉,从而在CCD相机上生成二维的频域全息图,这个全息图记录了所有检测脉冲关于瞬态事件的相位调制信息。由于所有的检测脉冲都在同一时间从同一原点产生,因此它们在目标处存在时空上的叠加。

在图像重建过程中,首先采用一维傅里叶逆变换将空间轴转换为入射角,这样便在空间频域分离出5个探测脉冲。其次,通过对每个探测脉冲相关的全息图区域进行开窗、移动和逆变换等操作,得到5条相位条纹,如图13(b)所示。最后,将这些条纹输入到层析图像重建算法中,恢复出瞬态场景的演化过程。重建出的瞬态场景的成像速度可达4×1011frame/s,对应的时间分辨率为2.5ps,序列深度达5帧@128×128pixel。图13(c)展示了典型的强激光脉冲在熔融石英玻璃中传播引起的非线性光学动力学过程,从重建结果中可以看到:脉冲在7.4ps内经历了自聚焦;然后在9.8ps出现了一个从主脉冲分离出来的上空间瓣,归因于激光成丝现象;之后在12.2ps,剖面中心附近产生了一个陡壁折射率“空洞”,表明所产生的等离子体引起了折射率的负变化,局部抵消了激光引起的非线性正折射率变化。SS-FDT具有序列深度大、可记录复杂振幅、沿探测脉冲传播方向观察动态事件的能力。但是,这种基于稀疏角度的离散采样会产生严重影响重构图像质量的伪影,限制了成像的空间和时间分辨率。

2.2.2压缩超快成像技术

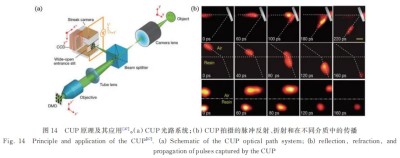

2014年,Gao等[37]首次提出了基于压缩感知(CS)的超快成像技术(CUP),光路系统如图14(a)所示,动态场景目标首先通过成像镜头、筒镜和显微物镜组成的成像系统成像在数字微镜器件(DMD)上。DMD上加载二维随机编码,经DMD反射的编码动态场景由筒镜和显微物镜组成的成像系统收集,在条纹相机的光电阴极面上成像。CUP采集数据时,条纹相机的入口狭缝完全打开,条纹相机中的扫描控制模块对动态场景感应的光电子进行线性偏转,轰击荧光屏产生可见光图像,在一次曝光中由CCD捕获到不同时刻叠加混合的编码图像,最后利用CS图像重构算法获得不同时刻的序列图像。

CUP成像系统具备以1011frame/s的成像速度捕捉非重复瞬态演变事件的能力,单次成像序列深度可达350帧。与STAMP、FINCOPA和FRAME等其他超高速和极高速成像技术相比,CUP单次拍摄可记录的成像帧数最多。图14(b)为CUP记录的飞行脉冲反射和折射等超快过程,但每一帧图像的空间分辨率还不是很高,只有1.4lp/mm[37,80]。CUP技术的提出为研究瞬态现象的演化过程提供了一种新的技术途径。2015年,Liang等[81]将CUP与飞行时间相结合,提出了三维物体测量方案(ToF-CUP),该方案借助CUP较高的时间分辨率能力,计算光从不同深度到达相机的时间差,得到物体的三维轮廓信息。2017年,Thompson等[82]将CUP应用于细胞的荧光寿命观测。

同年,Liang等[83]利用皮秒脉冲的散射产生马赫锥,并利用CUP拍摄了光学马赫锥现象。Cao等[84]记录了皮秒脉冲光斑的时空演化情况。

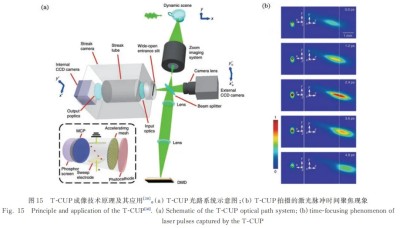

2018年,Liang等[38]为了进一步提高CUP的成像速度,提出了trillion-frame-per-secondCUP(T-CUP)。具体光路设置如图15(a)所示,与CUP不同的是,T-CUP采用了剪切速度更快的飞秒条纹相机,同时引入了另一CCD来提供空间域强度约束作为图像重建算法的先验条件,该方法一定程度上提高了重建图像的空间分辨率和对比度。图15(b)为T-CUP记录的激光脉冲时间聚焦的演化过程,成像速度达1013frame/s,达到了极高速成像水平,相比CUP提高了100倍,单次拍摄序列深度超过300帧。

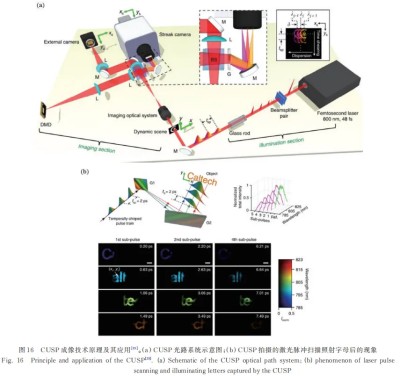

2020年,Wang等[39]利用飞秒脉冲照明与CUP系统相结合,开发出成像速度更快的压缩超快成像系统(CUSP),创下了新的成像速度纪录,具体光路如图16(a)所示。在主动工作模式下,CUSP利用具有超短时间间隔的脉冲序列作为照明光束,脉冲序列通过目标场景后由DMD完成空间编码,同时在条纹相机前放置光栅对携有动态场景信息的编码脉冲再按照光谱频率进行分离,最后由条纹相机扫描偏移后成像到CCD上。CUSP经协同光谱编码、脉冲空间分散、时间剪切和基于压缩感知的图像重建算法后,成像速度提升至7×1013frame/s,相比CUP和T-CUP,分别提高了700倍和7倍,成像序列深度也提升至1000帧,相比CUP和T-CUP,提高了3倍左右。图16(b)为CUSP记录的啁啾脉冲序列斜入射字母后的时空演化过程。在被动模式下,CUSP没有飞秒脉冲照明,其余光路部分与主动模式类似,可以5×1011frame/s的成像速度记录空间、时间和波长(x,y,t,λ)4个维度信息。

同年,加州理工学院Kim等[45]提出了相位敏感压缩超快成像技术(pCUP),用以观察透明介质中的相位变换过程。pCUP拍摄相位变化具有极大优势,其自身的被动式成像、成像帧数较多等优点得到了充分发挥。Lai等[47]将图案化光阴极集成到条纹相机中,使超快压缩成像拓展到了紫外波段。Yang等[53]提出一种多维度压缩超快成像系统(HCUP),将光谱测量与CUP相结合,实现了与CUSP被动模式类似的成像能力,并得到了1.72nm波长分辨率的快速光谱和图像信息,其中成像速度也达到了5×1011frame/s,重建图像的横向和纵向空间分辨率可达1.26lp/mm和1.41lp/mm。2021年,该课题组[54]利用气体相位时空转换器来替换CUP光路中的条纹相机,实现了速度为1013frame/s的压缩超快成像。Ding等[55]将ToF-CUP和HCUP结合,提出了spectral-volumetriccompressedultrafastphotography(SV-CUP),其能够在单次曝光下同时获取三维空间、时间和光谱(x,y,z,t,λ)5个维度信息,实现了立体动态场景的高光谱超高速成像。

以上提到的相关技术主要围绕CUP的成像速度、成像维度两个方面进行展开。目前在提升成像速度方面,主要依赖时间分辨率更高的条纹相机,最高速度已经达到了7×1013frame/s,已经能够满足大部分瞬态过程的成像需求。在成像维度方面,也已经引入了光谱、相位和三维空间的超快成像,扩展了成像的信息量。

2.2.3多重曝光的频率识别算法成像技术

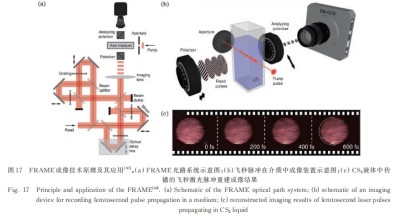

2017年,Ehn等[50]提出一种基于多重曝光的频率识别算法成像技术,简称FRAME,通过加载不同调制方向的探测子脉冲记录的光信息编码,在频域中识别并重建出不同时刻的信息,具体工作原理如图17(a)和图17(b)所示。一束超短脉冲经分束镜分成4个子脉冲,每个子脉冲都设置有一定的时间延迟,对应不同的时刻。4个子脉冲的强度分布分别受到具有相同周期但不同方向的光栅调制,可以产生具有正弦强度的脉冲探针,随后具有不同角度空间调制的照明图案叠加照射到待捕获的动态场景上完成曝光,即编码过程,最后利用频率识别算法提取出4帧原始动态场景图像。图17(c)为FRAME系统记录的飞秒脉冲激光通过CS2液体的演化过程,成像速度达5×1012frame/s@1002×1004pixel,空间分辨率达到~15lp/mm。但遗憾的是,完成一次拍摄只能获取4帧图像,这显然是限制其广泛应用的一个重要因素。如果还想进一步提升帧数,光路中还需设置更多的探测支路对应不同时刻的图像,这将会大幅增加分幅光路的元件数量和光路系统的复杂程度。

2.2.4压缩超快光谱时间成像技术

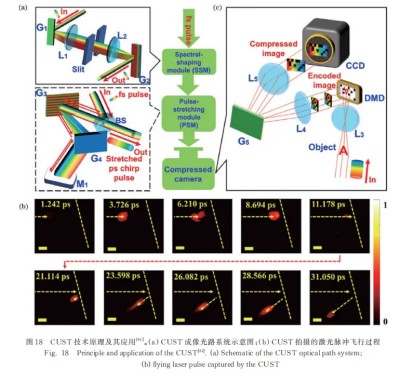

2019年,Lu等[61]结合STAMP和CUP的成像思路,提出了压缩超快光谱时间(CUST)成像技术。如图18(a)所示,其光路系统主要由光谱整形模块(SSM)、脉冲延展模块(PSM)和压缩相机3部分组成。在SSM中,一束飞秒脉冲通过一对光栅(G1和G2)和一组透镜(L1和L2)组成的4f整形系统,利用傅里叶平面上的可调谐狭缝来选择特定的脉冲频谱。在PSM中,飞秒脉冲经另一组光栅(G3和G4)得到时域拉伸,转换为皮秒啁啾脉冲,并作为动态场景的照明探测光源。压缩相机部分与STAMP原理相似,但不是将子脉冲在空间上完全分开,而是只需要利用光栅G5将携带动态场景信息的脉冲分开,间隔为像元级尺寸,并使用DMD进行编码。图18(b)为CUST记录的激光脉冲的飞行过程,其成像速度达3.84×1012frame/s,序列深度为60,光谱分辨率可以达到亚纳米级别。与STAMP相比,CUST的序列深度提高了约10倍,但由于较高的数据压缩比和优化不足的重建算法,其空间分辨率的表现并不理想。

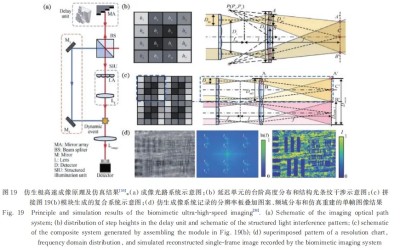

2.2.5多视场宽时域仿生极高速成像

2023年,朱启凡等[59]受到螳螂虾小眼和复眼结构启发,提出具有紧凑结构、多视场和宽时域特点的极高速成像方法,简称为BEHSI,具体的成像原理如图19所示。该技术采用空间角复用即利用不同方向或者间距的条纹结构光图案去叠加时序图像,经过曝光成像到一幅图像上,然后在频域中进行解码实现时序图像的重建。

具体的光路系统设置如图19(a)所示,一束飞秒脉冲经分光棱镜(BS)分为两束,一束探测脉冲经过由反射镜阵列构成的延迟模块,其中中心对称的两个反射台阶高度相同,相邻台阶高度差为h,c为光速,成像系统的分幅时间(Δt)即脉冲的延时时间可以计算为

由于台阶的特殊设计,可以产生多对延时的脉冲序列。随后,先后到达的脉冲序列通过由微透镜阵列和会聚透镜组成的结构光照明单元后,在会聚透镜的后焦面形成干涉条纹,且干涉条纹的方向与两个子透镜中心连线垂直,每个照明脉冲与透镜阵列中的子透镜一一对应,从而获得具有不同结构光图案的先后脉冲序列,最后由成像系统和探测器收集。假设子透镜中心位置为Di,微透镜焦距为f,波长为λ,则条纹间距e满足的公式为

由于单个仿生小眼的照明区域范围有限,因而可通过拼接多个小眼系统实现较大视场的照明区域,照明区域的大小随着子眼系统拼接数量的增多而增大,如图19(c)所示。

该成像模式的实现与FRAME具有一定的相似性,二者都采用了结构光条纹图案对时序图像进行压缩和解算,但不同的是结构光的生成方式。与FRAME成像技术相比,BEHSI采用干涉法产生结构光照明条纹,条纹对比度更好,成像系统也更为简单,在系统成本与应用便捷性方面具有一定的优势。为了标定该成像系统的空间分辨率,作者利用分辨率板做了相关的静态模拟仿真实验,以不同位置的分辨率板作为瞬态事件的不同时刻。图19(d)为经过图案叠加和频域重建求解后得到的对应时刻的图像信息,仿真实验的成像速度可达1.2×1013frame/s,空间分辨率为80.6lp/mm。

以上介绍的这些代表性编码计算超高速和极高速成像技术各有优缺点。SS-FDT所面临的挑战是如何解决稀疏角度的离散采样导致伪影的问题,主要原因源于采样不足,即在记录瞬态过程时,采集的角度数量过少,使得在图像重建中出现缺失或失真,为了解决这一问题,未来的研究可能更多需要集中在这个方面。CUST的创新在于记录了动态场景的时空光谱信息,但是成像质量还有待提高。而FRAME由于序列深度非常有限,在某些瞬态过程中可能限制了对瞬态现象细节的全面捕捉。BEHSI是一种结构紧凑、多视场和宽时域的极高速成像技术,但实验验证结果仍需加强。近年来在高速成像领域取得显著进展的是CUP及其相关衍生类技术,但也面临着不可避免的一些挑战和问题,通过在动态场景上加载随机编码并使用压缩感知算法进行重构。然而,这种压缩过程导致图像的空间分辨率受到限制,使得成像结果在空间上不如直接超高速和极高速成像技术的分辨率高。此外,数据的采集和处理需要使用高度复杂的算法,这些算法的设计和优化对获取高质量图像至关重要,但也增加了系统的复杂性和计算负担。随着技术的不断发展,这些挑战有望逐步得到解决。

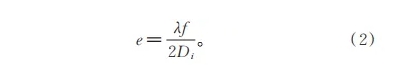

到此为止,分别从系统成像原理、成像性能参数等方面对两大类成像方式下的10余种代表性的超高速和极高速成像技术进行了介绍。表1总结了这些技术的部分指标参数来对比它们的性能。

3 超高速和极高速光学成像技术存在的问题及发展前景

3.1时间分辨率与空间分辨率相互制约

时间分辨率和空间分辨率都是高速光学成像技术的重要指标,但如何同时获取高时间与空间分辨率是目前超高速和极高速成像技术所面临的一个挑战。在传统的光学成像系统中,理想空间分辨率是由光学衍射极限决定的,理论值δ=0.61(λ/NA),主要受到波长和数值孔径影响,在可见光范围内约为200nm[86],而实际中会受到系统其他因素的影响,如系统调制传递函数(MTF)、探测灵敏度、信噪比等。而时间分辨率则取决于探测器的采集速率,通常可以达到微秒量级。当被研究的物体处于微米到纳米尺度时,相机对物体的成像要求不仅是高空间分辨率,而且需要同时满足较高的时间分辨率。因为,即使是一个缓慢运动的事件在微小的长度尺度内发生,它所需要的时间分辨率也是非常高的。例如,想要在1μm的空间分辨率下观察一个缓慢运动的物体(移动速度为1m/s),不产生运动模糊,成像所要求的时间分辨率至少需要满足1μs,对应的成像速度为106frame/s[87]。但是,在众多光学成像技术中,想要得到更高的时间分辨率,就要牺牲一定的空间分辨率,想要获取更高的空间分辨率,就要损失一定的时间分辨率,在时-空分辨率极限探测上类似不确定性原理,一个指标的提升往往面临着另一个指标下降,鱼与熊掌不可兼得。

在追求时间分辨率方面,一些成像技术,如CUP、T-CUP和CUSP,时间分辨率可以达到亚皮秒甚至几百个飞秒,可以记录飞行脉冲的轨迹,但重建图像的空间分辨率都不是很高,通常在亚毫米到几十微米的范围内。另外,像STAMP、FRAME的时间分辨率都可以达到皮秒量级,但图像的空间分辨率也都是几十微米左右[43,50]。CUST的时间分辨率最快可达260fs左右,但空间分辨率却受到相当大的限制,甚至在几百微米的范围内[61]。由于以上超高速和极高速成像技术通常采用的都是基于固体成像器件的探测器,即宽场成像的方式,空间分辨率不仅难以突破光学衍射极限,而且为了保证超高成像速度和较短曝光时间,图像的质量也会受到很大影响,产生失真或者模糊的现象。

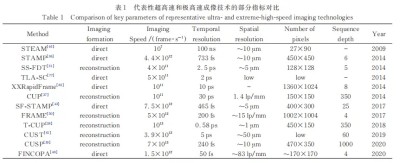

在追求空间分辨率方面,Rust等[88]和Huang等[89]提出的随机光学重建显微成像技术(STORM)可以用来研究细胞内源蛋白的超分辨定位,其空间分辨率可以达到20nm左右,甚至打破了光学衍射极限,如图20所示。然而,由于每个子图像只能定位有限数量的离散荧光分子,为了获得高分辨率的样品显微图像,需要合成数万甚至上千万幅原始图像。这导致获得一帧图像通常需要较长的时间,目前最快也需要大约几十秒。

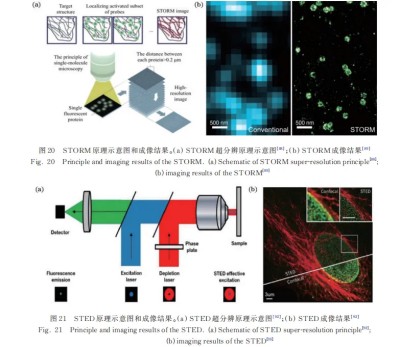

Hell等[90-91]提出的受激发射损耗(STED)荧光显微技术可以实现20~70nm左右的空间分辨率,由于STED采用扫描成像技术,因此其时间分辨率受到每个扫描点停留时间的影响,通常在几十毫秒量级。Paës等[92]和Poudel等[93]对其工作原理和成像结果进行了总结,如图21所示。

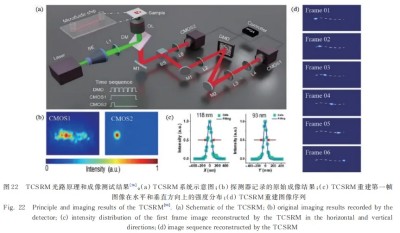

Gustafsson[94]提出了结构光显微成像技术(SIM),该技术利用莫尔条纹将原本超出系统截止频率的高频信息(对应高空间分辨率)移到低频部分从而使信息能够被系统探测到,实现分辨率的提升,通常可以达到100nm。虽然该技术无须扫描,但是时间分辨率仍受制于结构光加载速度和探测器采集速度[95],最快也在毫秒范围以内。空间分辨率和时间分辨率之间的矛盾严重阻碍了精细结构高速动态的观察。为了克服这一矛盾,He等[96]提出了一种时域压缩超分辨显微成像技术(TCSRM),具体如图22所示。该技术将增强的时域压缩显微成像方法和基于深度学习的超分辨率图像重建技术相结合,其中增强的时域压缩显微成像方法用于提高成像速度,即提升时间分辨率,而基于深度学习的超分辨率图像重建用于实现空间分辨率的增强。TCSRM可以同时实现以每秒1200帧的成像速度和100nm的空间分辨率的成像。

3.2成像序列深度选择

在超高速和极高速成像技术领域中,序列深度指在快速连续图像捕获中可以记录的图像帧数。序列深度的选择在高速成像中非常重要,它决定了可以捕获和还原的时间范围。拍摄前需要预估研究对象的时间尺度,不同的应用可能需要不同的序列深度来捕捉特定时间尺度内的变化。更大的序列深度允许更长的时间跨度,因为更多的图像帧被记录下来,从而可以提供更全面的动态信息。例如,研究快速化学反应可能需要较短的时间间隔和较大的序列深度,而研究较慢的生物过程可能需要较长的时间间隔和较小的序列深度。如果高速相机以每秒1千帧的成像速度拍摄并记录1千帧图像,那么序列深度为1000,可以捕捉1s的动态过程。比如,CUP类的成像系统采用的是压缩编码的形式,一次曝光就可以压缩数百帧的图像信息,序列深度可以达350~1000[37,39]。相反,如果序列深度较小,将会难以获得瞬态场景完整的演化过程,导致重要过程信息的丢失。STAMP尽管可以获得百飞秒量级的时间分辨率,但受限于光路中频谱编码的数量,序列深度为6,只能捕获约2ps以内的动态过程。FRAME因为分光支路的设置,序列深度只能达到4。显然这些还不能满足一些超快场景拍摄的需求。此外,选择序列深度时还需要权衡存储和处理能力之间的关系。增加序列深度意味着需要更多的存储空间来保存连续的图像序列,同时也需要更多的计算资源来处理和分析这些数据。如果被观察的事件很短暂,较大的序列深度可能并不必要,因为它可能会导致冗余数据。以存储容量为512GB的PhantomTMX7510为例,它可以76000frame/s的成像速度记录12位色深、1280×800分辨率的视频图像,连续存储达到4.4s[68]。第三个方面仍需要考虑曝光时间和采样率,较大的序列深度可能需要更大的采样率和较短的曝光时间,以避免图像模糊或信息丢失。

总而言之,在超高速和极高速成像中,选择适当的序列深度需要权衡待测场景的时间尺度、存储能力和计算资源、曝光时间和采样率等因素。根据这些方面,确定最佳的序列深度,以便捕捉到关键的动态过程并获得有意义的结果。

3.3编码计算超高速和极高速成像质量的提高

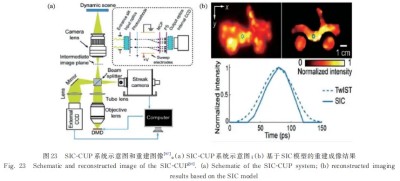

对于超高速和极高速成像技术,除了追求高时空分辨率和权衡序列深度外,提高成像质量也是非常重要的。在高速成像中,为了捕捉快速的事件,通常需要牺牲图像的质量或分辨率来实现高速捕捉,这可能导致图像失真或模糊。尤其是采用编码成像方式的超高速和极高速成像技术,因为成像过程中压缩编码通常会舍弃图像中的某些细节和冗余信息,从而导致一定程度的信息丢失,尽管在适度压缩的情况下这些损失可能是可接受的,但在高压缩比下,图像的细节和边缘可能都会受到明显的损失,从而导致压缩后的图像质量下降,影响图像的准确性和可用性。因此,为解决这一问题,可通过改进光路硬件系统来提升重建图像的质量。例如,Zhu等[97]提出了一种可改善CUP图像质量的space-andintensity-constrained(SIC)重建模型,该模型将外部CCD提供的空间和强度约束作为成像光路的额外先验信息,相比传统的两步迭代阈值TwIST算法,提升了重建算法的质量,如图23(a)所示。数值模拟和实验数据表明,SIC重建恢复的动态场景边界更清晰,特征对比度更高,伪影也相对更少,如图23(b)所示。

Liang等[83]提出了双通道互补编码方案,解决了单一编码过程中空间信息丢失的问题,从而有助于获得更高质量的图像重建结果。随机编码的选择也会显著影响图像的重建质量,Yang等[98]将遗传算法结合到CUP技术中,利用优化的编码重新捕捉动态场景并提高图像重建质量。Yang等[99]还提出了多通道编码模型,通过增加编码通道的数量来提高系统的采样率,可以提升重建图像的准确性。此外,不同的算法对编码重建图像质量也具有重要的影响,因为重建算法负责将经过压缩和编码的图像数据解码和还原为原始图像。

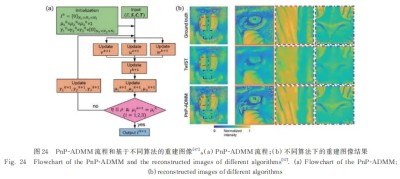

Lai等[47]将具有即插即用算法框架的交替方向乘子法(PnP-ADMM)应用于CUP图像重建,并使用块匹配3D滤波去噪(BM3D)方法去除噪声。如图24所示,相比TwIST算法,PnP-ADMM在抑制图像分辨率的各向异性方面展现较好的性能,能够较准确恢复图像的空间细节,减少图像扭曲和模糊。

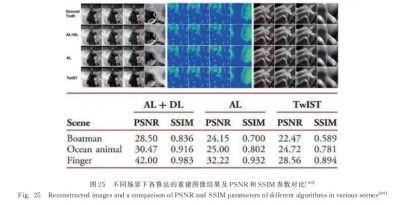

随着计算能力的不断进步,尤其是深度学习(DL)为代表的人工智能技术引入,涌现出了一系列新的智能重建算法,可进一步提高图像质量,减少伪影和失真,并增强压缩成像的性能。例如,Yang等[100]利用惩罚项参数依赖性较小的增广拉格朗日(AL)算法减小了伪影出现的概率,一定程度上改善了重建图像的质量。随后,他们[101]又将DL与AL相结合,通过对数据集的学习,优化了稀疏域和相关迭代参数。如图25所示,相比AL算法,该方法将峰值信噪比(PSNR)和结构相似性指数(SSIM)分别提高了约4dB和0.1左右。

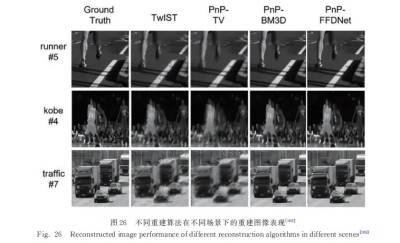

Yao等[102]采用了广义交替投影(GAP)的TV-BM3D联合重建算法,充分利用了图像在梯度域的稀疏性和图像的非局部相似性,从而确保了更高质量的图像重建。相比TwIST,GAP的PSNR和SSIM分别提高了约3dB和0.3。Shen等[103]受PnP-ADMM框架的启发,使用了一种基于fastandflexibledenoisingnetwork(FFDNet)的深度学习模型,提出了PnP-FFDNet算法,其利用神经网络的高级去噪算法来解决优化问题,充分发挥了联合优势。它通过学习图像中的噪声特征和纹理特征来实现图像去噪,利用PnP-ADMM的迭代过程,将图像去噪问题转换为多个子问题的求解,从而实现了更高效的图像去噪。无论是在基准数据集还是真实的压缩成像数据上,该方法相比PnP-BM3D平均减少了约96%的运行时间,并显示出较好的图像重建结果。如图26所示,相比TwIST算法,PnP-FFDNet的平均PSNR接近30dB,提高了大约4dB,SSIM也有小幅的提升。

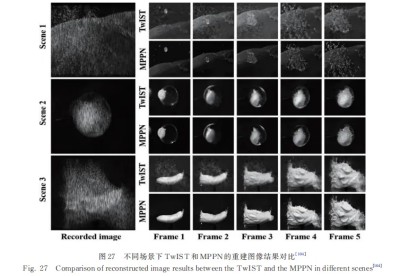

2023年,Wu等[104]提出了一种自适应即插即用(AdaptivePnP)的算法,考虑到预先训练的网络参数可能不是特定测试场景的最佳选择,采用在线(online)的更新方法,根据特定的动态场景和成像模型,自适应更新深度去噪先验网络中的参数,在成像硬件系统变化的情况下该算法依然能够重建出高质量的动态场景。该研究团队将额外的稀疏先验引入物理增强深度神经网络中,形成用于编码成像的多先验物理增强神经网络(MPPN),进一步解决了PnP-FFDNet容易导致的成像伪影问题,且提升了神经网络的物理可解释性,如图27所示。

以上介绍的代表性重建算法中,以DL为代表的智能算法是以后发展的一个趋势。特别是以PnP算法为框架的网络,将先进的卷积神经网络去噪算法FFDNet应用于子问题求解过程中,与传统使用TV去噪的TwIST算法相比,在重构指标和重构图像质量方面都取得了一定的改进;同时,与基于BM3D的优化算法相比,在不损失重构性能的前提下显著缩短了重构时间,可促进编码计算超高速和极高速成像技术的实际应用。研究出更优的智能重构算法将是提高编码计算超高速和极高速图像质量的关键。

3.4未来发展展望

虽然存在上述问题,但超高速和极高速光学成像技术在未来拥有巨大的发展潜力。未来,超高速和极高速光学成像技术将会在“极高速帧率、核心成像元件、成像更精细、计算更智能、跨学科应用”5个方面继续快速发展。其中,核心指标帧速率将会向大于1014frame/s的水平发展,以更迅速地捕捉极短时间内的变化。同时在保持极高速的帧速率下,成像的空间分辨率向超分辨水平(<200nm)发起挑战。研究人员将会努力寻求新的技术手段去继续追求更高的时间分辨率、更小的空间分辨率和更大的序列深度,以观察微观世界更快速的过程,如电子在分子层面的运动,这将需要更强大的阿秒激光器和精密的光学系统。此外,计算成像和深度学习的结合将会在未来超高速和极高速成像技术中发挥更重要的作用,大大提升图像处理的效率和成像质量。在核心成像元器件方面,设计和制造更快速响应、更高灵敏度和更低噪声的感光元件已成为必然的发展趋势,其可同时满足在超高速和极高速成像条件下的大数据传输、存储和处理要求。还有未来如何实现多通道或多模态的超高速或极高速成像元件,以在同一时间获取不同波段或模态的瞬态信息等,这些问题需要在光学、电子工程、计算机科学和物理学等多个学科领域进行深入研究和协同合作才能得到逐步解决,推动超高速和极高速成像技术的发展,拓展其在生物医学、纳米科学、材料科学、信息科学、工业制造等领域更广泛的应用。

总的来说,尽管超高速和极高速光学成像技术面临挑战,但未来发展前景仍然非常光明。随着不断的创新和跨学科合作,研究人员有望克服当前的限制,开拓更多领域的应用,推动科学和工程的发展,为解决一系列瞬态基础问题提供强大的工具。

4 结论

回顾和对比了近年来新兴的超高速和极高速光学成像方法如STAMP、FINCOPA、FRAME、SS-FDT、CUST、和CUP等技术的原理和成像性能。分析了它们是如何突破传统图像传感器的限制,以获得更高的成像速度、成像质量和序列深度等的。由于这些成像方法是近些年才发展起来的,预计它们将在未来得到进一步发展。虽然这些方法用一个或多个参数的特异性换取更高的成像速度,但在以下方面还有进一步改进的空间。1)如何对时-空分辨率相互制约关系进行取舍,做出符合物理规律的权衡与选择,从而打破技术壁垒,兼具高时间分辨率与高空间分辨率成像。2)引入更智能的计算成像算法,比如训练深度神经网络以学习复杂的图像特征,这对处理高速成像数据中的噪声和伪影是非常有效的,从而提高图像的清晰度;利用更加优化的编码解码策略,如多通道编码、互补编码等多采样方案,使其更适应瞬态过程和超高速和极高速成像的需求,解决可能存在的数据缺失或采样不足的情况,从而从有限的数据中重建出高质量的图像;引入实时在线反馈机制,根据成像过程中产生的数据不断调整算法参数,这种实时的优化可以确保在不断变化的场景中获得最佳的图像质量。3)系统硬件的改进升级对超高速和极高速成像性能的提升具有很大的促进,如使用高功率稳定的超快激光光源、更快速高灵敏度的大面阵探测器、高刷新频率的编码器件、成像性能更好的物镜等。